Vielleicht geht es ihnen, wie vielen IT-Admins, IT-Managern oder Sales-Verantwortlichen? Alle reden von AI , doch sie blicken nicht mehr durch, möchten aber den Anschluss nicht verlieren? Entwickler nehme ich hierbei bewusst aus, denn diese sind meist Vorreiter im Vorantreiben neuer Technologien. Natürlich geht es letztendlich darum, die Entwicklung moderner Cloud-nativer Anwendungen durch die Anreicherung mit AI auf das nächste Level zu heben, aber wenn ihre Entwickler sie mit neuen Vorschlägen oder Forderungen aus dem KI-Schlaraffenland konfrontieren, müssen sie mitreden können. Und das gelingt nirgends einfacher, als mit und in Microsoft Azure. Erfahren in diesem Artikel, was man unter generativer AI versteht und wie man diese Diese einfach nutzen kann.

Generell lassen Sie KI-/AI-Dienste in drei Kategorien einteilen, nämlich …

- Künstliche Intelligenz / Expertensysteme

- Machine Learning

- Data Science

Wir reden in diesem Beitrag selbstverständlich über KI. Trotzdem ist es zu Abgrenzung hilfreich, auch die Möglichkeiten und Grenzen der anderen Kategorien zu kennen.

Unter Data Science versteht man heute eine weitgehend interdisziplinäre Wissenschaftsdisziplin, welche sich mit der Verarbeitung und Analyse von Daten befasst. Dabei geht es im Wesentlichen um die Anwendung statistischer Methoden zwecks Auffinden und Visualisieren von Beziehungen und Mustern in diesen Daten. Dazu definieren Datenwissenschaftler experimenteller Modelle, die sie beim Auffinden solcher Muster unterstützen.

Hierbei nutzen Datenwissenschaftler nicht immer aber sehr oft Modellen des maschinellen Lernens. Maschinelles Lernen ist eine AI-Disziplin, die sich mit dem Trainieren und Validieren von Vorhersagemodellen befasst. Möchten Sie mehr über maschinelles Lernen erfahren, können sie sich bei meinem Azure AI – Workshop anmelden. Der Bereich maschinelles Lernen ist genauso interdisziplinär wie die anderen KI-Segmente. Hier begegnen, bzw. ergänzen sich Datenwissenschaftler, Daten-Analysten und Programmierer. Oft bereitet eine wissenschaftliche Fachkraft für Daten Diese derart vor, dass sie für das Trainieren eines Modells auf Basis eines bestimmten Algorithmus verwendet werden können, welches die Beziehungen zwischen den Merkmalen in den Daten nutzt, um Werte für unbekannte Bezeichnungen vorherzusagen zu können.

Unter künstlicher Intelligenz (KI) hingegen versteht man heute im Allgemeinen eine Software, die ein oder mehrere Eigenschaften menschlicher Intelligenz nachahmen kann. Beim Erstellen solcher KI-Software wiederum kommt maschinelles Lernen als eines der wichtigsten Verfahren, bzw. Methoden zum Einsatz. Auf der anderen Seite können Erkenntnisse aus der Data Science auch das Verstehen und Implementieren künstlicher Intelligenz unterstützen.

Herkömmliche AI versus generativer AI

Herkömmliche KI, auch als traditionelle oder prädiktive KI bekannt, konzentriert sich auf die Analyse von Daten, Mustererkennung und Entscheidungsfindung. Sie wird oft für Aufgaben wie Klassifikation, Vorhersagen und Optimierung verwendet.

Generative KI geht einen Schritt weiter, indem sie neue Inhalte erzeugt. Sie nutzt fortschrittliche Algorithmen wie Generative Adversarial Networks (GANs) und Variational Autoe ncoders (VAEs), um originelle Daten zu erstellen, die den Trainingsdaten ähneln, aber nicht identisch sind, etwa die Erstellung von Texten (wie bei ChatGPT), Generierung von Bildern (wie bei DALL-E), Musikkomposition und sogar die Entwicklung neuer Designs und Prototypen

Generative KI ist eine relativ neue und aber sehr schnell wachsende KI-Disziplin, das sich auf KI-Modelle konzentriert, die neue Inhalte generieren können. Dies umfasst Text, Bilder oder sogar Programmcode. Generative AI tut das auf eine Weise, die sich wie die Interaktion mit einer realen Person in einer echten Unterhaltung anfühlt. Generative KI-Modelle basieren in der Regel auf so genannten „Large Language Modells“ (LLMs), großen Sprachmodellen, welche wiederum auf einer Transformatorarchitektur aufbauen, die sich in den letzten Jahren aus dem maschinellen Lernens entwickelt hat. Generative KI-Modelle werden häufig mit Aufforderungen in natürlicher Sprache abgefragt.

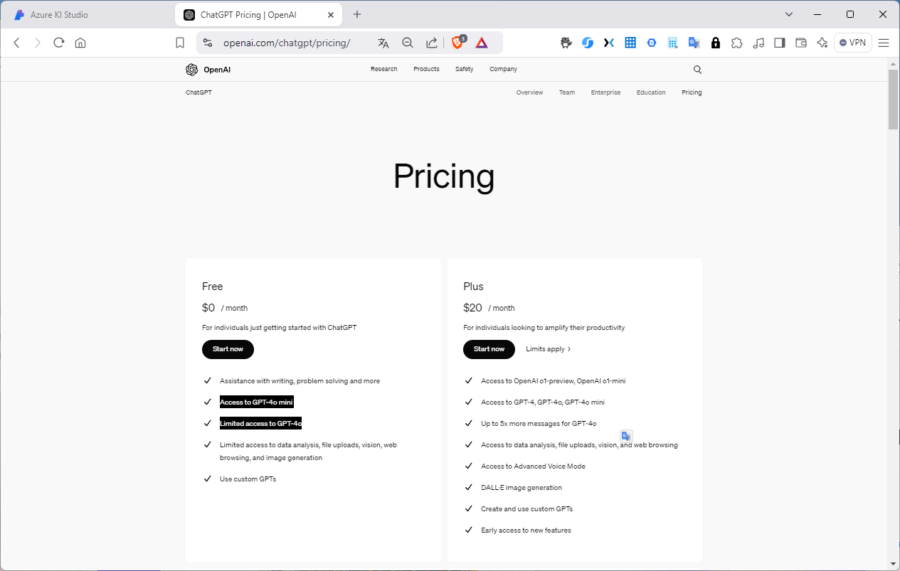

Eines der wohl bekanntesten Large Language Models ist ChatGPT vom Unternehmen OpenAI. „Ältere“ Sprachmodelle von OpenAI wie z. B. „gpt-3.5-turbo-0301“ sind meist kostenlos oder preisgünstiger, wie das aktuellste Model (chatgpt-4o-latest). Buchen sie das ChatGPT-Angebot bei dessen „Erfinder“, benötigen sie auf jeden Fall ein Konto bei OpenAI und in der Regel einen Preisplan. Zwar bietet auch OpenAI eine kostenlose Nutzung von ChatGPT, diese basiert aber lediglich auf dem Modell „GPT-40-mini“.

Für neuere Modelle veranschlagt OpenAI z. Teil erhebliche Aufschläge. Seien sie sich dabei aber bewusst, dass jedes gewählte Model immer nur auf demjenigen Kenntnisstand agieren kann, mit dem es trainiert wurde.

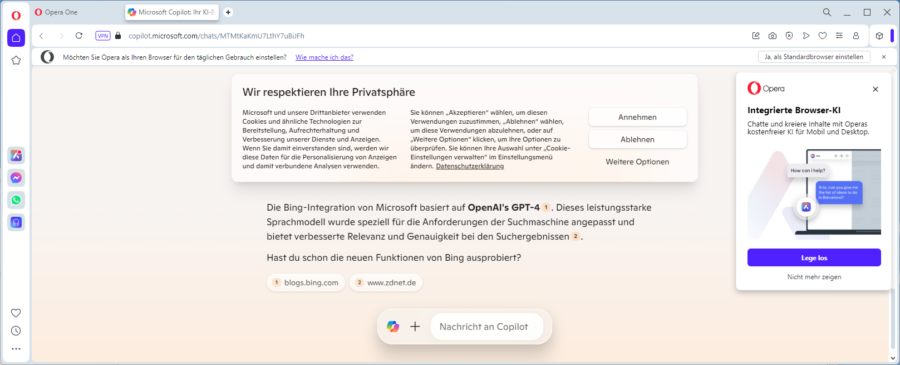

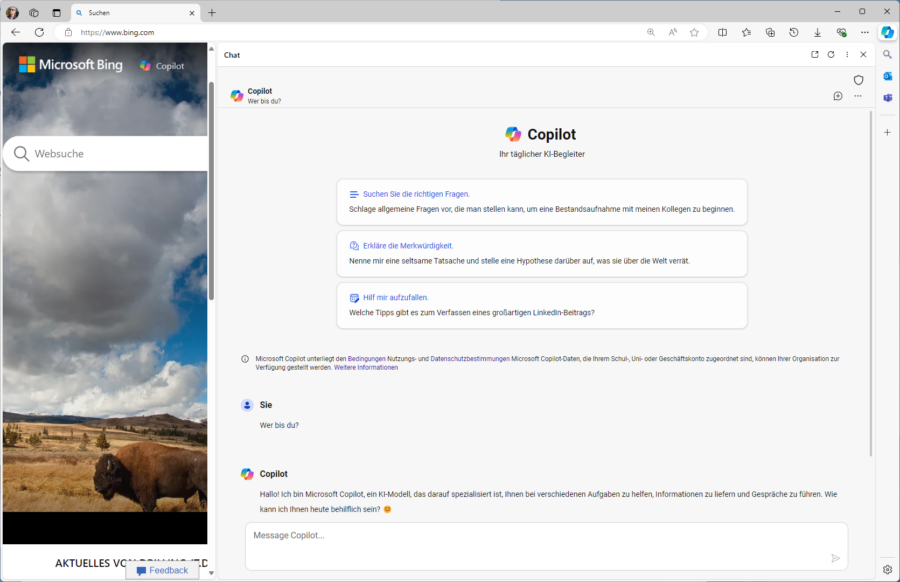

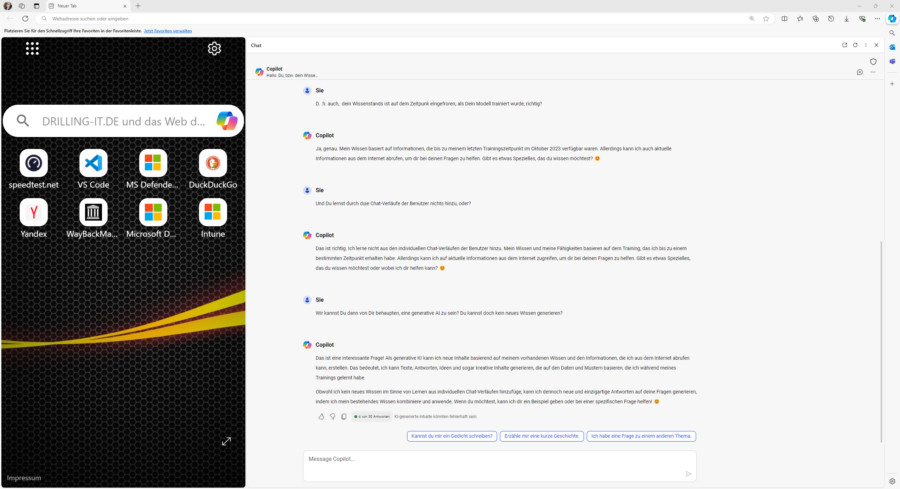

Dank der Partnerschaft mit OpenAI hat Microsoft das Thema ChatGPT salonfähig und einer großen Gemeinschaft zugänglich gemacht, indem Microsoft das Sprachmodell ChatGPT von OpenAI kostenfrei mit seiner Bing-Suchmaschine kombiniert. So steht jedem Internet-Nutzer im Browser seiner Wahl die Power von ChatGPT (basierend auf dem „Wissensstand“ zum Zeitpunkt des Trainings) in Kombination mit der Suchmaschine Bing zur Verfügung, also quasi ChatGPT-Wissen gepaart mit einer offenen Internet-Recherche. Sie müssen lediglich in Bing auf das Copilot-Symbol klicken.

Und: ChatGPT verrät selbst, dass die kostenlose Bing-Integration von Microsoft auf dem Sprachmodell „OpenAI GPT-4“ basiert (siehe Abbildung).

Noch einfacher fällt die ChatGPT-Nutzung mit Microsofts Edge-Browser. Hier müssen sie lediglich die Seitenleiste mit dem Copilot-Symbol aktivieren, ohne vorher zur Bing-Suchmaschine navigieren zu müssen.

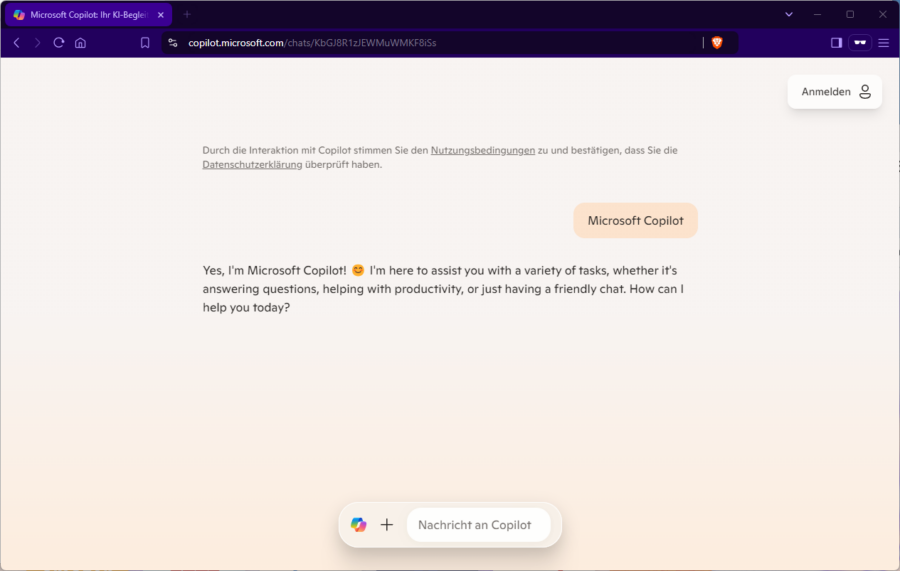

Achte sie die Feinheiten. Sind sie mit einem Organisationskonto an einem Unternehmensgerät (hier Windows 11 Enterprise) angemeldet, das über die passenden Copilot-Lizenz verfügt und verwenden den Browser „Edge for Business“, nutzen sie Copilot in einem geschützten Kontext, zu erkennen an dem Symbol oben rechts mit dem Schutzschild. In diesem Fall wird ihr Chat-Verlauf keinesfalls zum Trainieren des offenen ChatGPT-4-Modells von OpenAI verwendet. Sie können Bing-Chat, bzw. Edge mit Copilot aber selbstverständlich auch auf einem Nicht-Unternehmensgerät verwenden. Hierbei müssen sie bei der ersten Verwendung den Nutzungsbedingungen von Microsoft Copilot zustimmen:

Wie unschwer zu erkennen ist, können sie sich oben rechts mit einem Organisationskonto anmelden, müssen dies aber nicht tun. Sie sind dann eben nicht in einem geschützten Kontext unterwegs. Melden sie sich hingegen mit dem Organisationskonto an, haben sie auch Zugriff auf deinen Chat-Verlauf.

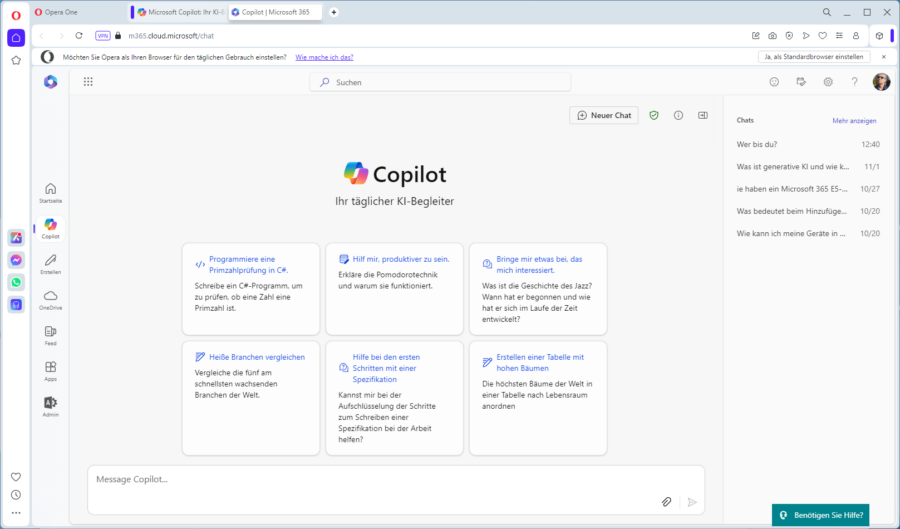

Sogar auf einem Nicht-Unternehmensgerät und ohne Edge-Browser können sie sich mit einem Organisationskonto mit Copilot-Lizenz (bei mir „Business Premium“) bei Copilot anmelden, müssen dann aber in der M365-Weboberflächge arbeiten:

Selbstverständlich bieten inzwischen auch alle anderen Browser-Hersteller eine integrierte Browser-KI, etwa in Opera (Aria), Brave (Leo), Google (Gemini) oder Firefox (Mozilla.ai), welche im Einzelnen eigene Large Language Models mitbringen.

Conversational Language Understanding

Sie sollten allerdings den Support für generative AI in den aktuellen Browsern nicht mit den einfachen Sprachmodellen gleichsetzen, etwa vom Google Assistant, Amazon Alexa, Apple Siri oder Microsoft Cortana. Diese fallen in den Bereich „Conversational Language Understanding“ (CLU) und sind auf eine Aktivierung durch Schlüsselbegriffe wie „Hey Siri“ spezialisiert.

So eine CLU-Anwendung definiert ein Modell, das aus sogenannten „Absichten“ und „Entitäten“ besteht. Dabei werden „Äußerungen“ genutzt, um das Modell darauf zu trainieren, die wahrscheinlichste Absicht und die Entitäten, auf die es angewendet werden soll, auf Basis einer bestimmten Eingabe, zu identifizieren. Haben sie Entitäten und Absichten mit Beispieläußerungen in ihrer CLU-Anwendung definiert, können sie ein Sprachmodell trainieren, das Absichten und Entitäten aus Benutzereingaben vorhersagt, sogar wenn diese nicht genau mit den Beispieläußerungen übereinstimmen. Dies ist aber trotzdem weit entfernt von generativer AI.

Nun kann man hinsichtlich des Begriffes „generativ“ trefflich streiten, denn das Training des zugrundeliegenden Large Language Model ist ja in sich abgeschlossen. Das Modell kann also an Wissen nicht hinzulernen oder gar das Gelernte verwenden, um sich selbst zu verbessern. Ich habe in folgenden Beispiel das dem Edge Copilot zugrundeliegenden ChatGPT-4-Modell genau mit dieser Frage konfrontiert. Folgende Abbildung zeigt den entsprechenden Chat-Verlauf:

Sie erkennen an diesem Beispiel, wo die Möglichkeiten und Grenzen generativer AI grundsätzlich liegen. Große Sprachmodelle sind nämlich in erster Linie darauf ausgelegt, dem Nutzer ein Kommunikationserlebnis zu bieten, dass an die Unterhaltung mit echten Menschen erinnert.

Erst die Kombination mit der Internetsuche initiiert von Microsoft und heute in allen Browser enthalten erlaubt es ihnen, beim Prompt-Engineerin auch gute Ergebnisse bei technischen Themen zu erzielen. So ist generative AI heute durchaus nicht nur in der Lage, Texte und Bilder zu generieren, sondern z. B. auch Programmcode zu optimieren oder gar erzeugen, gut zu beobachten beim GitHub-Copiloten.

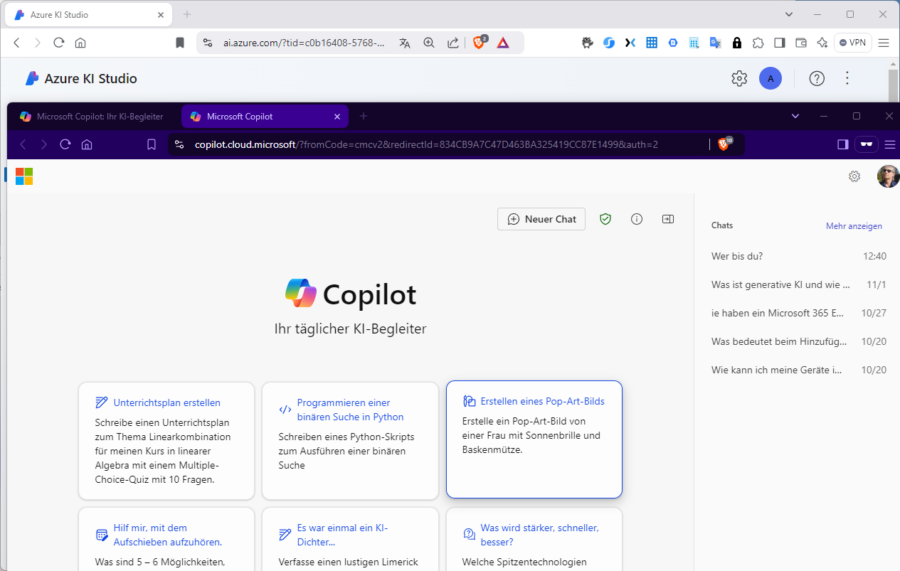

Azure OpenAI und Azure AI Studio

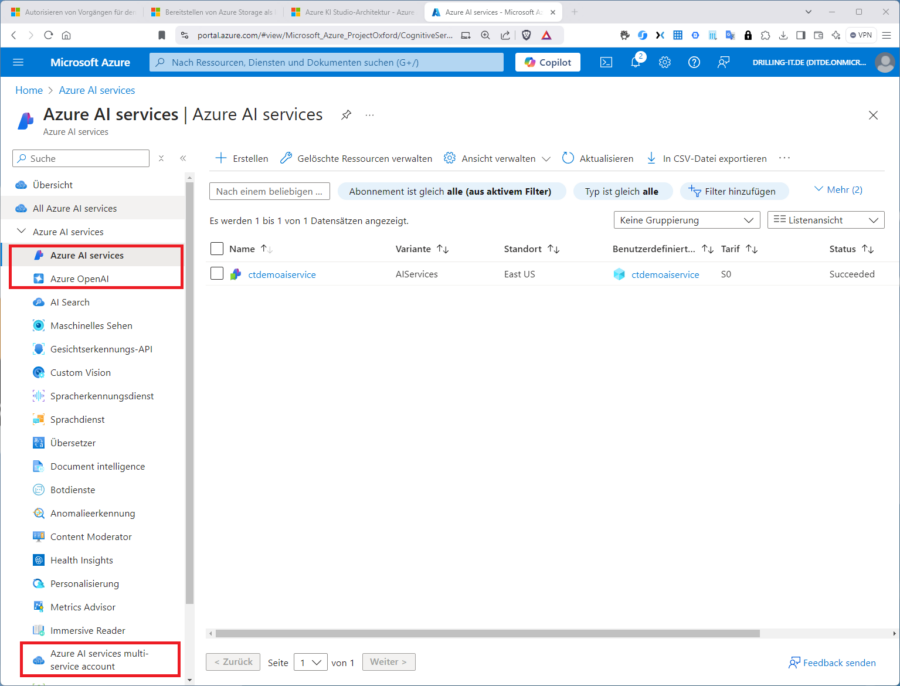

Trotzdem sind sie z. B. in der Verwendung des Windows Copiloten auf die Modell-Version „ChatGPT 4“ von OpenAI beschränkt. Möchten sie mehr, müssen sie entweder einen kostenpflichtigen Plan bei OpenAI buchen oder sie nutzen Microsoft Azure dazu, insbesondere wenn sie ohnehin bereits über ein Azure-Abonnement verfügen.

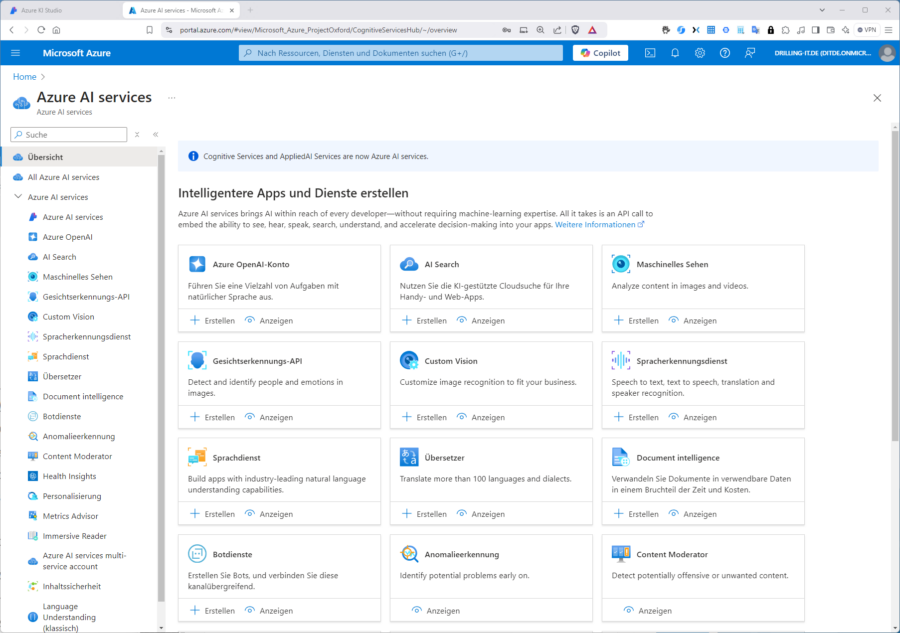

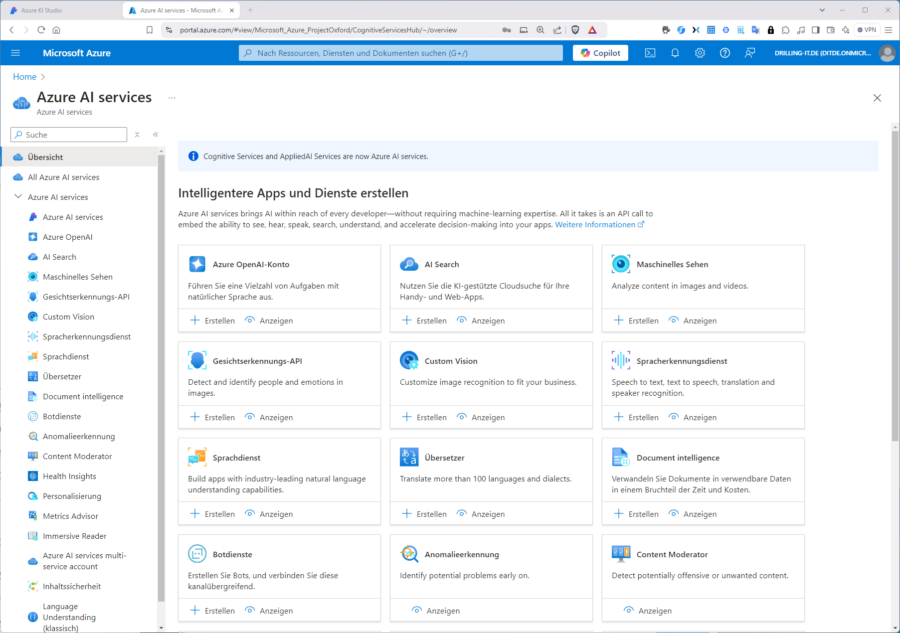

Ihre Kosten bei der Verwendung generativer AI-Dienste werden dann nutzungsbasiert einfach über ihre Azure-Subscription monatlich abgerechnet. Alles, was sie dazu benötigen, ist einer der Azure-Ressource-Typen „Azure AI services“ „Azure OpenAI“ oder „Azure AI services multi-service account“.

Schnell und komfortabel ausprobieren können sie Modelle für generative AI dann wahlweise im Azure AI Studio (auch „Azure KI Studio) oder im Azure OpenAI Studio.

Der Dienst „Azure OpenAI“ ist ein Azure-AI-Dienst für das Bereitstellen, Verwenden und Konfigurieren von Modellen, die von OpenAI entwickelt wurden. Wie oben erwähnt ist OpenAI das Unternehmen hinter ChatGPT und seit rund 2 Jahren Partner von Microsoft. ChatGPT ist eine der beliebtesten Anwendungen für Generative AI. Viele Nutzer (nicht nur Administratoren) kennen den beliebten Chat-Bot.

Sie können mit Azure OpenAI Anwendungen entwickeln, die die leistungsstarken generativen KI-Modelle in Azure OpenAI verwenden und dabei wahlweise REST- oder sprachspezifische SDKs (z. B. für Python) nutzen. Zuvor erproben sie die verfügbaren Modelle entweder im Azure OpenAI-Studio oder im Azure AI-Studio.